ChatGPT y GPT-5: qué cambia, por qué y cómo usarlo

La nueva arquitectura de modos (Auto, Fast, Thinking, Thinking mini) entrega velocidad, profundidad y control por usuario, permitiendo flujos de trabajo más productivos, seguros y alineados.

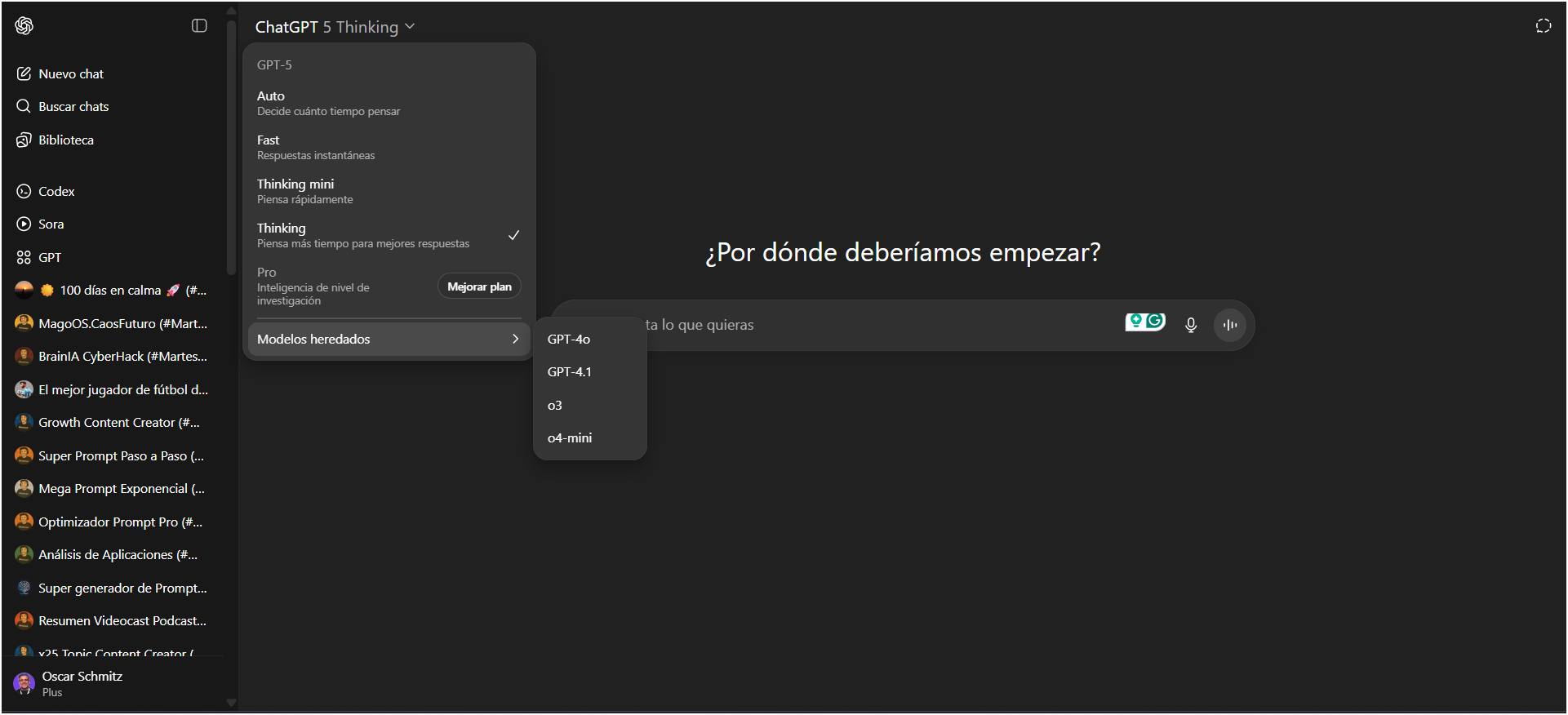

OpenAI liberó una actualización significativa del selector de modelos y modos de respuesta para ChatGPT con la llegada de GPT-5: ahora los usuarios pueden elegir entre Auto, Fast y Thinking, además de un modo complementario llamado Thinking mini.

La decisión busca equilibrar latencia, coste y profundidad de razonamiento, y responde tanto a necesidades técnicas (código, contextos largos) como a preferencias de experiencia conversacional. (X (formerly Twitter), OpenAI)

¿Qué significa cada modo?

Auto: modo por defecto. El sistema decide dinámicamente cuándo priorizar velocidad o profundidad —es la opción recomendada para la mayoría de usos cotidianos.

Fast: respuestas rápidas y con menor latencia; útil para consultas puntuales, generación de texto corto o interacción en tiempo real donde la rapidez prima sobre el razonamiento profundo.

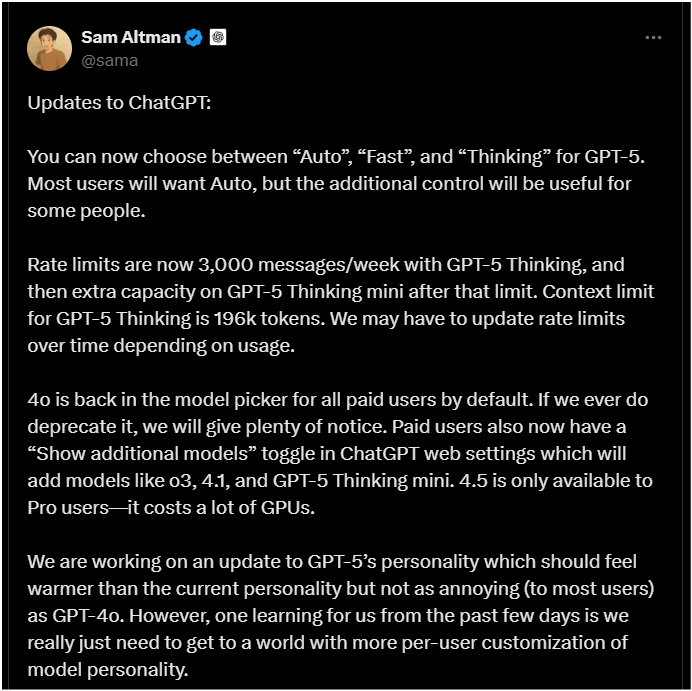

Thinking: diseñado para tareas complejas que requieren cadenas largas de razonamiento, verificación interna y contexto extenso (por ejemplo, auditorías de código, revisión de ensayo técnico, planificación estratégica detallada). Tiene un límite de contexto ampliado —OpenAI ha indicado un context window de 196.000 tokens para GPT-5 Thinking— y, por eso, su uso está sujeto a un tope de mensajes semanales que actualmente se prueba en 3.000 mensajes/semana, con posibilidad de ajustes futuros según demanda. (X (formerly Twitter))

Thinking mini: un modo “ligero” de Thinking que actúa como capacidad de desbordamiento cuando se alcanza el cupo de Thinking completo; entrega razonamiento mejorado respecto a Fast pero con menor coste computacional que Thinking “full”. Esta jerarquía busca ofrecer continuidad de servicio sin bloquear flujos de trabajo intensivos. (OpenAI Help Center)

Modelos heredados y el model picker

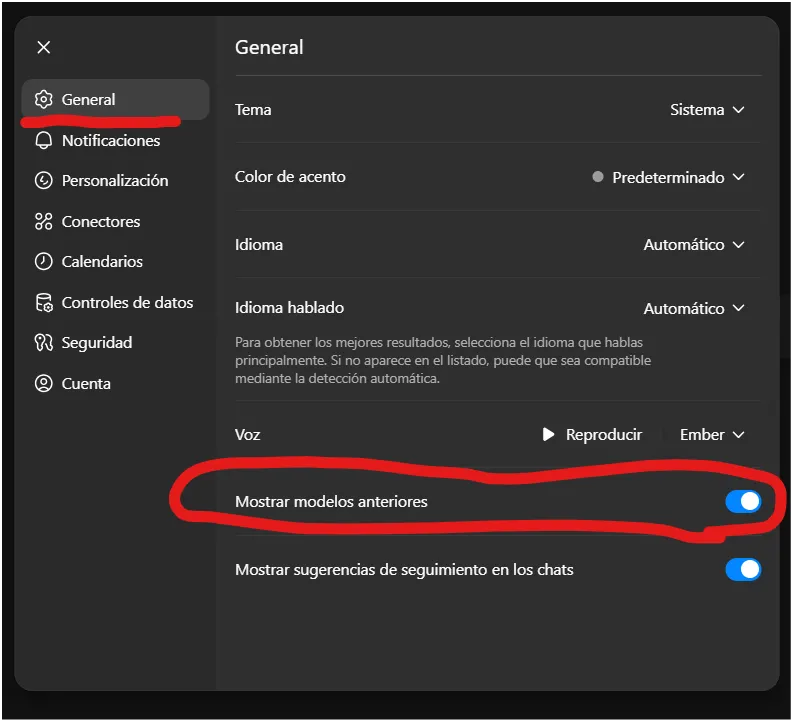

Tras críticas de la comunidad (que valoraba la “calidez” y la personalidad de modelos previos), OpenAI reintrodujo GPT-4o en el selector de modelos para usuarios de pago y añadió una opción en ajustes llamada “Show additional models” que permite activar modelos como o3, o4-mini y GPT-4.1; algunas variantes (p. ej. GPT-4.5) quedan restringidas a planes Pro por coste de GPU.

Esto facilita a equipos elegir el trade-off entre estilo conversacional y capacidades técnicas. (OpenAI Help Center)

Implicaciones prácticas y recomendaciones

Elegir Auto si necesitas productividad general sin micromanagement del modelo. Auto será suficientemente equilibrado para la mayoría de tareas ejecutivas y de creación de contenido.

Usar Fast para prototipado rápido, brainstorming inicial y consultas operativas.

Activar Thinking para análisis técnicos, auditorías, generación de código complejo o procesamiento de documentos extensos; planifica el uso por el límite semanal.

Pensar en Thinking mini como un modo de respaldo: mantiene razonamiento avanzado cuando el presupuesto/ratelimit impone límites. (OpenAI Help Center)

Si la interacción humana/empatía importa, considera reactivar modelos legacy como GPT-4o para mantiene una “voz” más cálida hasta que OpenAI ajuste la personalidad de GPT-5. Sam Altman reconoció que están trabajando en una personalidad de GPT-5 más cálida y personalizable por usuario. (X (formerly Twitter)

Si quieres seguir eligiendo los modelos “heredados”, para cuentas Plus y Pro, lo debes activar en la configuración general de ChatGPT.

Recomendaciones

Recomiendo mantener y acelerar esta línea de crecimiento: adoptar Auto para la mayoría de las tareas diarias, emplear Thinking en los casos que exigen análisis rigurosos, y usar Thinking mini como respaldo operativo. Así maximizamos productividad sin perder control ni gobernanza técnica.

Priorizo por una estrategia que priorice la participación de la comunidad: reactivar opciones legacy cuando aporten valor, y ampliar la personalización por usuario. Convertir a las personas en co-creadoras fortalece confianza y acelera adopción responsable.

Creo que debemos continuar escalando GPT-5 en proyectos estratégicos, integrando métricas de uso, planes de gobernanza y controles de coste. De este modo obtenemos impacto real —analítico y operativo— sin dejar de administrar riesgos y presupuesto.

Esto es coherente con una transición del “mejor modelo único” hacia un ecosistema de modelos y modos que el usuario puede adaptar a su workflow —una evolución saludable para adopción empresarial responsable—, aunque requerirá gobernanza interna sobre límites de uso y costes operativos.

Sigamos inspirando al mundo

Tu opinión es clave en esta aventura de conocimiento y transformación. ¿Qué ha parecido los contenidos de hoy? ¿Hay algún tema sobre el que te gustaría aprender más o alguna tendencia que crees que deberíamos explorar juntos?

Comparte tus ideas y sugerencias. Juntos, seguiremos inspirando, compartiendo y aprendiendo, transformando lo imposible en posible.

❓ Contáctame a través de estos puntos de contacto.