LM Studio: La Guía definitiva para instalar una IA privada en tu PC (Potenciada por GPT-OSS)

El lanzamiento de GPT-OSS completa el ecosistema de IA privada. Te muestro cómo usar LM Studio para ejecutar el "cerebro" del modelo en tu PC, creando una experiencia de chat 100% tuya.

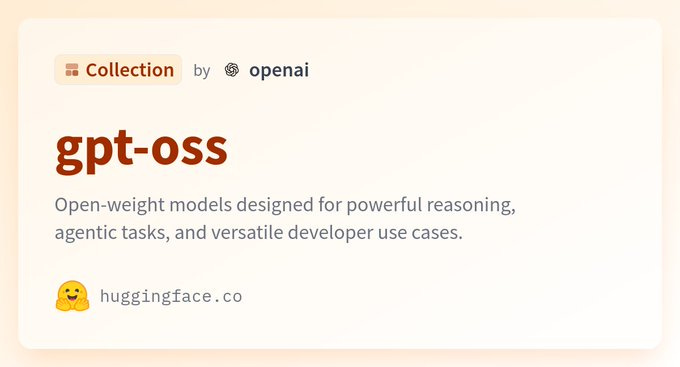

Con el reciente lanzamiento de los modelos abiertos de OpenAI, como GPT-OSS, la frontera de la inteligencia artificial avanzada se ha abierto para todos.

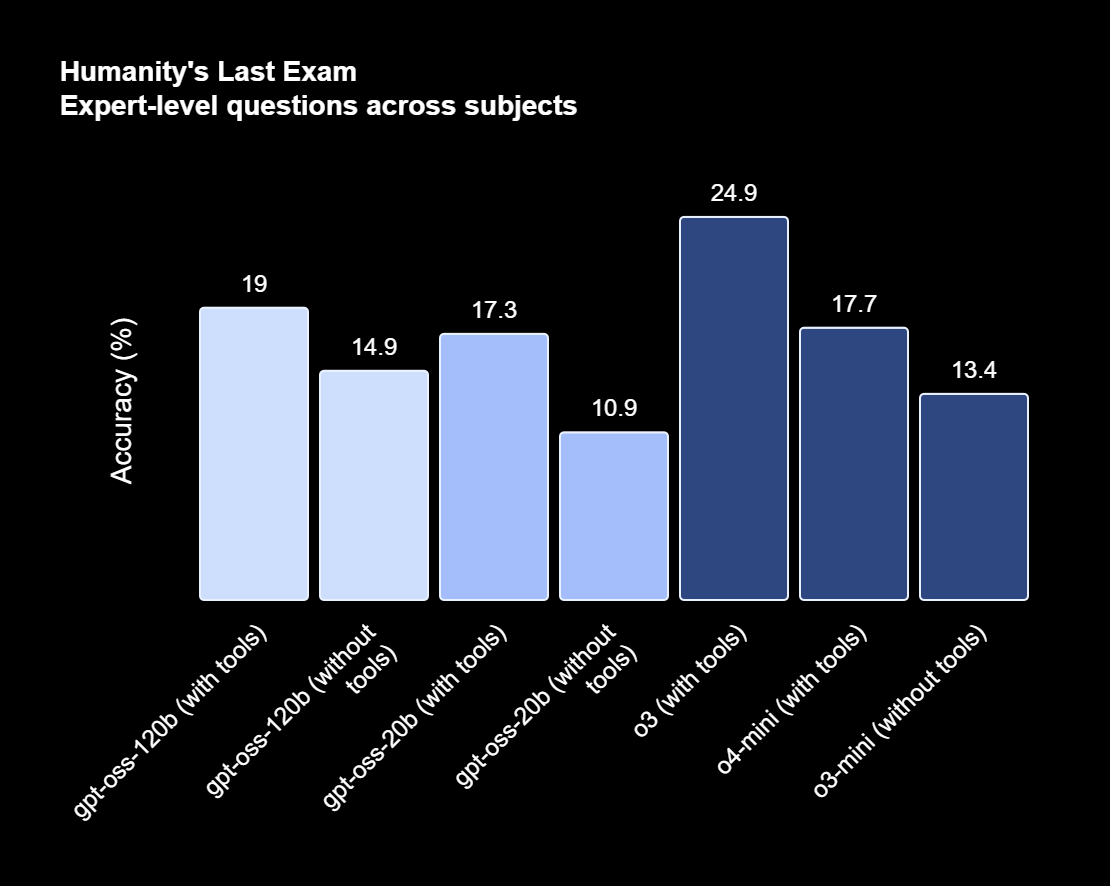

Con GPT-OSS-120B y GPT-OSS-20B, OpenAI amplía la frontera de los modelos de razonamiento para todo el mundo.

En este nuevo escenario, herramientas como LM Studio se vuelven más esenciales que nunca. Si alguna vez has querido el poder de un gran modelo de lenguaje ejecutándose de forma privada, segura y gratuita en tu PC, esta guía es tu punto de partida.

Lo que te voy a contar te dará un control sin precedentes sobre tus datos y tus proyectos de IA.

🚀 Coordinemos una sesión para generar la transformación que necesita tu empresa 💡 No esperes a que la disrupción golpee y te deje fuera del mercado ⏳ ¡Anticípate con contenidos para soñar, creer y crear el futuro! 🌍 Contáctame y juntos diseñaremos la transformación digital y exponencial 📩 que necesita tu organización 📈

Si estás recibiendo este correo por primera vez es que te has inscripto directo, te ha referenciado un amigo, o producto de la sincronización automática de mis listas de contactos, Linkedin y otras redes sociales, en caso que no te interese estos contenidos puedes desuscribirte con la opción que figura debajo en este newsletter.Introducción y objetivos: Tu propio laboratorio de IA, sin mirones

Imagina por un momento dejar de depender de servicios en la nube para cada consulta, para cada línea de código que necesitas depurar o para cada párrafo que buscas mejorar.

Imagina que toda esa potencia de cálculo y creatividad reside en tu propia máquina, accesible sin conexión a internet y, lo más importante, garantizando que tus datos sensibles y tus ideas innovadoras nunca salgan de tu control. Esto no es el futuro; es la realidad que LM Studio pone hoy sobre tu mesa.

La transformación digital no es solo adoptar herramientas, es adoptar soberanía sobre la tecnología.

En un entorno donde, según estudios de mercado de Statista para 2024, la inversión en IA empresarial sigue creciendo a un ritmo anual superior al 30%, la pregunta ya no es si usar IA, sino cómo usarla. LM Studio responde a esta pregunta de la forma más segura y personalizable posible.

El objetivo de esta guía: darte el conocimiento y la confianza para que instales, configures y exprimas cada gota de potencial de esta increíble aplicación, transformando tu PC en un centro neurálgico de inteligencia artificial privada.

Descripción general de la aplicación

LM Studio es una aplicación de escritorio gratuita, disponible para Windows, Mac y Linux, diseñada para simplificar radicalmente la ejecución de Modelos de Lenguaje Grandes (LLMs) de forma local.

Su propósito es eliminar las barreras técnicas: en lugar de lidiar con complejas líneas de comandos, dependencias y configuraciones de entorno, LM Studio te ofrece una interfaz gráfica (GUI) intuitiva y pulida.

Características principales:

Descarga de modelos simplificada: Integra un buscador para explorar y descargar miles de modelos de código abierto directamente desde el repositorio de Hugging Face.

Interfaz de chat intuitiva: Permite conversar con los modelos descargados de una manera muy similar a como lo harías con ChatGPT.

Servidor local compatible con OpenAI: Puede crear un servidor de inferencia en tu máquina con solo un clic, haciendo que tus modelos locales sean accesibles a través de una API compatible con la de OpenAI.

Control total de la configuración: Permite ajustar parámetros avanzados como el uso de la GPU (offloading), la memoria asignada y las particularidades de cada modelo.

Su gran diferencial en el mercado, frente a alternativas como Ollama (que es más orientado a la terminal), es precisamente su facilidad de uso y su enfoque visual. LM Studio está pensado para el usuario que quiere experimentar y utilizar la IA sin necesidad de ser un experto en DevOps.

Precios y modelos de pricing

Aquí viene una de las mejores noticias. A partir de una actualización en julio de 2025, LM Studio es completamente gratuito tanto para uso personal como para uso profesional/comercial.

Esta decisión estratégica eliminó la fricción para su adopción en entornos laborales, permitiendo a equipos enteros experimentar y desarrollar con la herramienta sin necesidad de licencias complejas.

El modelo de negocio de LM Studio se está orientando hacia servicios de valor añadido para equipos y empresas, que se lanzarán próximamente:

Community (Actual): Gratuito. Incluye la aplicación de escritorio completa, actualizaciones y la capacidad de crear una cuenta en el "Hub" para compartir artefactos públicos.

Teams (Próximamente): Será un plan de pago pensado para equipos que necesiten colaborar. Incluirá todo lo del plan Community más la capacidad de crear organizaciones y compartir artefactos privados en el Hub.

Enterprise (Próximamente): Destinado a grandes corporaciones, ofrecerá funcionalidades avanzadas como despliegues personalizados, inicio de sesión único (SSO), control de acceso a modelos (model gating), informes de administración y soporte prioritario.

Esta estructura freemium es brillante: te dan la herramienta principal sin coste para que descubras su valor y, una vez que se vuelve indispensable en tu equipo, te ofrecen las capas de colaboración y seguridad que una empresa necesita.

Instalación y configuración inicial

Empezar a usar LM Studio es un proceso notablemente sencillo. Olvídate de instalaciones complejas.

Requisitos técnicos:

Sistema Operativo: Windows (x64/ARM64), macOS (Apple Silicon M1/M2/M3/M4) o Linux (x64 con soporte AVX2).

RAM: Se recomiendan 16 GB de RAM como mínimo para ejecutar modelos de tamaño medio de forma fluida. Con 8 GB podrás experimentar con modelos más pequeños, pero para un uso serio, más RAM es siempre mejor.

Procesador (CPU): En Windows y Linux, es crucial que tu procesador soporte las extensiones AVX2. Puedes verificarlo en las especificaciones del fabricante (por ejemplo, en la web ARK de Intel).

Tarjeta Gráfica (GPU): No es obligatoria, pero sí altamente recomendable. Una GPU NVIDIA o AMD con suficiente VRAM acelerará drásticamente la velocidad de respuesta de los modelos.

Guía de instalación paso a paso:

Descarga: Ve a la página oficial, lmstudio.ai, y descarga el instalador correspondiente a tu sistema operativo.

Instalación: Ejecuta el archivo descargado. Es un instalador estándar que te guiará con instrucciones en pantalla. No hay configuraciones extrañas ni adware.

Primer Lanzamiento: Abre LM Studio. Te recibirá una pantalla de bienvenida. Puedes explorarla o saltar directamente a la acción.

Configuración inicial básica:

La primera vez que lo abras, te sugiero familiarizarte con la interfaz. A la izquierda, verás los iconos principales:

🔍 Discover (Descubrir): Para buscar y descargar nuevos modelos.

💬 AI Chat (Chat de IA): Para conversar con tus modelos.

🖥️ Local Server (Servidor Local): Para activar la API.

📁 My Models (Mis Modelos): Para ver los modelos que ya has descargado.

¡Y ya está! No necesitas registrarte ni iniciar sesión para empezar a descargar y usar modelos.

Exploración de funcionalidades clave

Aquí es donde reside la magia de LM Studio. Vamos a desglosar sus pilares.

Descubridor de Modelos (Integración con Hugging Face)

Esta es tu puerta de entrada al universo de los LLMs.

Cómo funciona: En la pestaña "Discover" (🔍), tienes una barra de búsqueda. Puedes buscar modelos por nombre (ej. "Llama 3.1", "Phi-3"), por creador (ej. "Meta", "Microsoft") o simplemente explorar las listas de tendencias. Lo más importante es que LM Studio se enfoca en los formatos compatibles, principalmente GGUF, que son versiones optimizadas (cuantizadas) para ejecutarse eficientemente en hardware de consumo.

Ejemplo práctico: Quieres un modelo bueno para programar y que no consuma demasiados recursos.

Ve a "Discover".

Busca "Code Llama".

En los resultados, verás diferentes versiones. Busca una que diga

Q4_K_MoQ5_K_M. Estas etiquetas indican el nivel de cuantización: un buen equilibrio entre rendimiento y precisión. Fíjate en el tamaño del archivo (RAM requerida). Un modelo de 7B (7 mil millones de parámetros) en formatoQ4_K_Mocupará unos 4-5 GB de RAM.Dale al botón "Download" y observa el progreso en la pestaña de descargas inferior.

Recurso Visual: Para una guía paso a paso sobre cómo elegir y descargar tu primer modelo, te recomiendo este video del canal IA Latino: IA GRATIS y FÁCIL! | Tutorial de LM Studio.

Chat de IA y Personalización

Una vez descargado un modelo, usarlo es tan fácil como seleccionarlo y empezar a escribir.

Cómo funciona: Ve a la pestaña "AI Chat" (💬). En la parte superior, selecciona el modelo que acabas de descargar. El modelo se cargará en la memoria (esto puede tardar unos segundos). Una vez listo, el área de chat se activará.

Configuraciones clave (panel derecho):

GPU Offload: Si tienes una GPU compatible, puedes deslizar esta barra para descargar un número de capas del modelo a la VRAM de tu tarjeta. Esto libera RAM y acelera enormemente las respuestas. Consejo: Empieza deslizando a la mitad y ve subiendo. Si el programa se vuelve inestable, baja un poco.

System Prompt: Aquí defines la "personalidad" o el rol del modelo. Por ejemplo: "Eres un asistente experto en marketing digital. Tus respuestas deben ser directas, accionables y basadas en datos".

Temperature: Controla la creatividad. Un valor bajo (~0.2) da respuestas más predecibles y fácticas. Un valor alto (~1.0) las hace más creativas y, a veces, erráticas. Un 0.7 es un buen punto de partida.

Ejemplo práctico: Quieres usar un modelo para generar ideas de posts para tu blog sobre cocina vegana.

Carga un modelo generalista como "Llama-3.1-8B-Instruct".

En el System Prompt, escribe: "Eres un creador de contenido culinario especializado en cocina vegana. Eres creativo, inspirador y tus ideas son fáciles de llevar a la práctica".

En el chat, introduce: "Dame 5 ideas para posts de un blog de recetas veganas para el invierno, que incluyan un ingrediente poco común".

Servidor de Inferencia Local (API compatible con OpenAI)

Esta es la funcionalidad que convierte a LM Studio en una herramienta para desarrolladores y power users.

Cómo funciona: Ve a la pestaña "Local Server" (🖥️). Selecciona un modelo para cargar y haz clic en "Start Server". ¡Listo! LM Studio ahora está exponiendo una API en tu

localhost(normalmente en el puerto1234).Compatibilidad con OpenAI: La API imita la estructura de la API de OpenAI. Esto significa que puedes tomar cualquier código o herramienta que funcione con OpenAI (como clientes de Python, JavaScript, etc.), cambiar la URL base a

http://localhost:1234/v1y funcionará con tu modelo local.Ejemplo práctico: Tienes un script de Python que usa la librería de OpenAI para corregir textos.

Código original (fragmento):

Python

from openai import OpenAI

client = OpenAI(api_key="TU_API_KEY_DE_OPENAI")

Código modificado para LM Studio:

Python

from openai import OpenAI

# Apunta al servidor local de LM Studio

client = OpenAI(base_url="http://localhost:1234/v1", api_key="not-needed")

El resto de tu código (

client.chat.completions.create(...)) funcionará sin cambios.Recurso Oficial: La documentación de LM Studio sobre esto es excelente: OpenAI Compatibility API | LM Studio Docs.

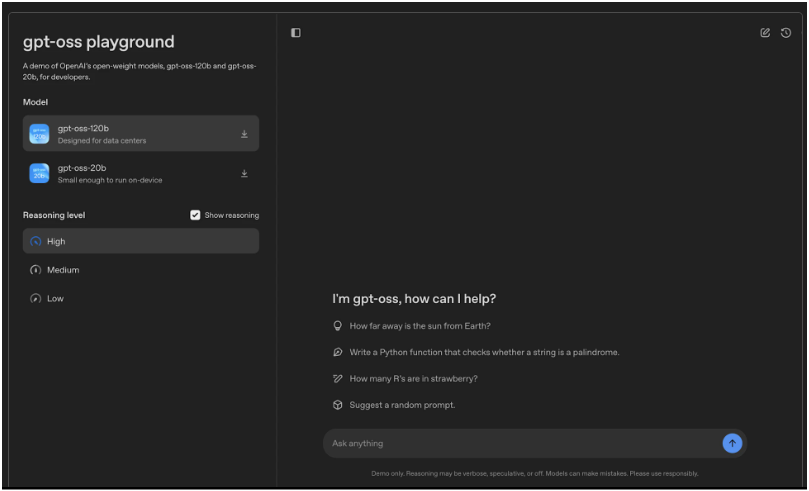

La configuración definitiva: LM Studio + GPT-OSS (Guía Oficial)

Este es el montaje que te dará el máximo poder. Usaremos LM Studio como nuestro servidor seguro y privado para ejecutar los modelos recomendados oficialmente por el equipo de GPT-OSS, y luego conectaremos su espectacular interfaz para interactuar con ellos.

El Objetivo: Utilizar uno de los modelos oficiales de gpt-oss.com de forma local y privada, combinando el poder de LM Studio y la experiencia de usuario de GPT-OSS.

Descargar en Hugging Face | Ver en GitHub | Prueba nuestros modelos

GPT-oss-120b: A large open model designed to run in data centers and on high-end desktops and laptops.

GPT-oss-20b: A medium-sized open model that can run on most desktops and laptops.

Paso 1: Descargar el Modelo Oficial (usando el motor LM Studio)

El sitio gpt-oss.com nos recomienda dos modelos principales, alojados en Hugging Face, que están afinados para funcionar a la perfección con su interfaz: uno de 7 mil millones de parámetros (más rápido y accesible) y otro de 70 mil millones (extremadamente potente, para equipos con hardware de alta gama y mucha RAM).

Para esta guía, usaremos el modelo de 7B, que es perfecto para la mayoría de las PC modernas.

Abre LM Studio y busca el modelo: Ve a la pestaña de búsqueda (el icono 🔍). En la barra superior, busca el nombre del repositorio oficial del modelo más pequeño. Generalmente, el equipo de GPT-OSS lo nombrará de forma clara, por ejemplo:

gpt-oss/gpt-oss-7b-gguf.Selecciona la Versión Correcta: En los resultados, verás el repositorio. A la derecha, aparecerá una lista de archivos. Busca la versión cuantizada recomendada. Una apuesta segura es siempre la que termina en

Q4_K_M.gguf, ya que ofrece el mejor equilibrio entre calidad y rendimiento.Descarga el Modelo: Haz clic en el botón

Downloady espera a que termine. Podrás ver el progreso en la parte inferior de la aplicación.

Paso 2: Iniciar el Servidor de LM Studio (Poner en Marcha el Motor)

Una vez descargado el modelo, vamos a "encenderlo" para que GPT-OSS pueda hablar con él.

Ve a la Pestaña del Servidor: Haz clic en el icono del servidor local (🖥️) en el menú de la izquierda de LM Studio.

Carga el Modelo GPT-OSS: En el menú desplegable de la parte superior, asegúrate de seleccionar el modelo que acabas de descargar (

gpt-oss-7b).Optimiza con la GPU (Recomendado): Si tienes una tarjeta gráfica dedicada (NVIDIA o AMD), utiliza el control deslizante de GPU Offload para mover al menos la mitad de las capas del modelo a la VRAM. Esto acelerará las respuestas de forma espectacular.

Inicia el Servidor: Haz clic en el botón verde

Start Server.¡Excelente! Tu motor está en marcha y listo. LM Studio ahora está exponiendo el modelo en la dirección

http://localhost:1234/v1, esperando las instrucciones de la interfaz de GPT-OSS.

Paso 3: Conectar la Interfaz Oficial (GPT-OSS)

Ahora, nos movemos a la aplicación GPT-OSS, que debes instalar siguiendo las instrucciones de su web oficial, https://gpt-oss.com/

Abre GPT-OSS y ve a la Configuración: Una vez ejecutada, busca el selector de modelos o el menú de configuración.

Configura la Conexión con LM Studio: La interfaz de GPT-OSS está diseñada para conectarse fácilmente a diferentes "backends".

Busca la opción para seleccionar LM Studio como proveedor de modelos.

En el campo Base URL (o similar), introduce la dirección de tu servidor:

http://localhost:1234/v1En el campo API Key, no necesitas poner nada. Escribe

not-neededo déjalo en blanco.Asegúrate de seleccionar el modelo correcto que está corriendo en LM Studio en la lista de modelos disponibles dentro de la configuración de GPT-OSS.

Guarda y Empieza a Chatear: Guarda los cambios. Ahora, la interfaz de GPT-OSS está completamente conectada a tu modelo local.

Resultado Final

Al escribir en la caja de chat de GPT-OSS, estás utilizando su interfaz avanzada, pero el procesamiento real de la información lo está haciendo el modelo gpt-oss-7b que se ejecuta de forma segura y privada en tu PC gracias a LM Studio.

Has logrado la configuración profesional definitiva: la mejor experiencia de usuario con la privacidad y el control de un sistema 100% local.

Casos de uso y ejemplos prácticos

Para Desarrolladores:

Asistente de codificación privado: Carga un modelo afinado para código (como "Code Llama" o "Phi-3 Coder") y úsalo para generar fragmentos de código, depurar errores, explicar algoritmos o traducir código entre lenguajes. Todo esto sin que tu código propietario salga de tu máquina.

Prototipado rápido de aplicaciones de IA: Usa el servidor local para conectar el LLM a tus aplicaciones en desarrollo. Puedes crear un chatbot para tu web, una herramienta de resumen de texto o un sistema de clasificación de emails, probando todo localmente antes de pensar en despliegues en la nube.

Para Escritores y Creadores de Contenido:

Brainstorming y superación del bloqueo del escritor: Usa un modelo creativo para generar ideas, titulares, estructuras de artículos o borradores iniciales. La interacción es instantánea y privada.

Análisis y resumen de documentos: LM Studio permite cargar documentos (PDF, TXT, etc.) en el contexto del chat. Puedes subir un paper de investigación y pedirle al modelo que te haga un resumen, extraiga los puntos clave o te explique conceptos complejos.

Para Profesionales de Negocios:

Análisis de datos confidenciales: Puedes cargar un archivo CSV con datos de ventas y pedirle al modelo que identifique tendencias o genere un resumen ejecutivo, con la certeza de que la información no se está enviando a ningún servidor externo.

Buenas prácticas y consejos

Elige el modelo correcto: No siempre el más grande es el mejor. Un modelo de 7B-8B bien cuantizado (

Q4_K_MoQ5_K_M) es a menudo más rápido y suficientemente bueno para muchas tareas. Reserva los modelos de +30B para tareas que requieran un razonamiento muy complejo y si tienes el hardware para soportarlos.La RAM es tu recurso más valioso: Cierra otras aplicaciones que consuman mucha memoria antes de cargar un modelo grande. La cantidad de RAM libre determina qué modelos puedes ejecutar.

Aprovecha el System Prompt: Sé muy específico en tus instrucciones iniciales. Un buen prompt de sistema mejora drásticamente la calidad y la coherencia de las respuestas.

Experimenta con los parámetros: No tengas miedo de jugar con la Temperature, Top K o Top P. Ajustarlos te ayudará a entender cómo modificar el comportamiento del modelo para adaptarlo a tus necesidades. Para una explicación detallada, el canal La Hora Maker tiene un excelente video: Configurando LM STUDIO: Los Parámetros que NADIE Entiende.

Recursos Multimedia y Referencias

Canal Oficial de LM Studio: Aunque no tienen un canal de YouTube muy activo, su Blog Oficial y su Documentación son la fuente de verdad.

Open models de OpenAI: Modelos avanzados de razonamiento abiertos y personalizables, diseñados para cualquier caso de uso y para funcionar en cualquier lugar.

Descargar en Hugging Face | Ver en GitHub | Prueba nuestros modelos

GPT-oss-120b: A large open model designed to run in data centers and on high-end desktops and laptops.

GPT-oss-20b: A medium-sized open model that can run on most desktops and laptops.

Tutoriales de la Comunidad (YouTube):

La Hora Maker: Tiene una playlist muy completa en español: Tutoriales LM Studio.

IA Latino: Ideal para una introducción rápida y clara en español.

Influencers en inglés: Canales como Matt Wolfe o AITrepreneur suelen cubrir LM Studio y sus novedades.

Comunidad de Discord: Es el principal canal de soporte. Puedes unirte para hacer preguntas, compartir tus proyectos y obtener ayuda tanto de la comunidad como de los desarrolladores. Enlace de invitación a Discord: https://discord.gg/aPQfnNkxGC.

GitHub: El proyecto tiene un GitHub donde puedes encontrar repositorios para sus SDKs y, aunque el tracker principal de bugs es más interno, es un buen lugar para ver el desarrollo.

Recomendaciones Finales

LM Studio no es solo una aplicación; representa la democratización de la IA generativa, devolviendo el poder y la privacidad al usuario final. Elimina la dependencia de las grandes corporaciones tecnológicas y te permite construir, experimentar y crear en tus propios términos.

En mi experiencia como consultor, las herramientas que triunfan son las que combinan poder y simplicidad, y LM Studio da en el clavo. Te ofrece el 90% de la funcionalidad que podrías necesitar para trabajar con LLMs a nivel local, con el 10% del esfuerzo que requerirían otras soluciones.

No te quedes atrás. Descarga LM Studio hoy mismo. Empieza con un modelo pequeño, de acuerdo a tus requerimientos de PC sino avanza con GPT-OSS.

Chatea con él, pídele que te ayude con una tarea, intégralo en un pequeño script. Experimenta la sensación de tener una IA superpotente trabajando para ti, en tu máquina y bajo tus reglas.

Ese es el primer paso para una transformación real de tu productividad y tu soberanía digital. ¡Manos a la obra!

Sigamos inspirando al mundo

Tu opinión es clave en esta aventura de conocimiento y transformación. ¿Qué ha parecido los contenidos de hoy? ¿Hay algún tema sobre el que te gustaría aprender más o alguna tendencia que crees que deberíamos explorar juntos?

Comparte tus ideas y sugerencias. Juntos, seguiremos inspirando, compartiendo y aprendiendo, transformando lo imposible en posible.

❓ Contáctame a través de estos puntos de contacto.