¿La Inteligencia Artificial nos está gobernando? Del algoritmo IA en el poder a la democracia aumentada

Cómo convertir la inteligencia artificial en un motor de derechos ciudadanos sin caer en la trampa de la automatización desigual. Diseño ético de la IA pública para simplificar al ciudadano.

De “¿sí o no?” a “¿cómo y con qué límites?”

En agosto de 2025 el primer ministro sueco, Ulf Kristersson, desató un vendaval al admitir que usa ChatGPT como “segunda opinión” para temas de gobierno.

La polémica no giró en torno a la legalidad, sino a la falta de credenciales, trazabilidad y responsabilidad de la herramienta (The Guardian).

Esa escena sintetiza el debate actual: la IA ya está dentro de la sala de máquinas estatal; la cuestión es quién la controla, con qué propósitos y bajo qué salvaguardas.

El lado luminoso: eficiencia y accesibilidad

Un Estado es, sobre todo, una fábrica de texto. En la primera prueba transversal con Microsoft 365 Copilot, la Administración británica midió un ahorro medio de 26 minutos diarios por funcionario—dos semanas de productividad por año que pueden redirigirse a tareas de alto valor público (gov.uk).

Además, asistentes conversacionales multilingües pueden ofrecer servicio 24/7, simplificar trámites, detectar inconsistencias en expedientes y traducir contenidos a lenguas locales o a lenguaje sencillo para adultos mayores.

Con un diseño centrado en el ciudadano, la IA se vuelve la brújula que transforma el laberinto burocrático en un mapa legible.

Riesgos sistémicos: de la confidencialidad al lock-in tecnológico

Confidencialidad y gobernanza. Sin un protocolo de clasificación y anonimización, los modelos devoran información sensible que puede terminar en manos de terceros—el caso sueco evidenció esa vulnerabilidad.

Sesgo y legitimidad. Los datos históricos reflejan desigualdades reales: si se alimenta un modelo con expedientes judiciales desbalanceados, la IA perpetuará ese sesgo en asignación de subsidios o inspecciones.

Dependencia y captura. Cuando los flujos críticos corren sobre un stack propietario cerrado, el Estado queda rehén de licencias, precios y agendas ajenas. El know-how gubernamental—prompts, datasets, métricas de evaluación—es un activo soberano que no admite pérdida ni clausura.

Atrofia de capacidades. Externalizar redacción, análisis y síntesis amenaza la memoria institucional y el pensamiento crítico que legitiman las decisiones públicas.

Marcos regulatorios que ya imponen el ritmo

La Unión Europea fijó un suelo común con el AI Act. Entró en vigor el 1 de agosto de 2024; las prohibiciones y obligaciones de alfabetización se aplican desde el 2 de febrero de 2025; los requisitos de gobernanza y los controles para grandes modelos generales rigen desde el 2 de agosto de 2025; y los sistemas de alto riesgo tendrán transición hasta 2027 (digital-strategy.ec.europa.eu).

En EE. UU., la Oficina de Presupuesto emitió el memorando M-25-21 que obliga a todas las agencias federales a inventariar casos de uso, documentar riesgos, mantener un humano con poder de veto y garantizar portabilidad antes de contratar IA (The White House).

El mensaje es claro: no es “IA sí o no”, sino “IA responsable o nada”.

Efectos colaterales que exigen vigilancia

Burocracia de la verosimilitud. Textos impecables pueden maquillar premisas erróneas y colar recomendaciones pobres bajo apariencia científica.

Delegación de responsabilidad. Siempre habrá tentación de culpar al algoritmo—“la herramienta lo sugirió”—diluyendo la rendición de cuentas.

Vigilancia selectiva. Un piloto que combine consumo eléctrico, denuncias y redes sociales para asignar inspecciones puede reforzar estigmas territoriales y crear un bucle de sospecha permanente.

Propaganda sintética. Agentes generativos capaces de testear miles de variantes por minuto amenazan la conversación cívica con micro-mensajes invisibles.

Escenarios virtuosos al alcance

Asesor Ciudadano: un LLM entrenado con leyes, jurisprudencia y estadísticas públicas, con citas verificables y system card abierta.

Repositorios soberanos: datasets y prompts estatales versionados y auditables bajo licencias públicas.

Cajas de vidrio: trazas de todas las interacciones, registros de variables de riesgo, y logging abierto a la ciudadanía (salvando datos personales).

Modelos federados: despliegues en nubes con enclave confidencial o regiones on-premise, desacoplados de los titanes tecnológicos.

Derecho a la vía humana: cualquier ciudadano puede impugnar una decisión automatizada ante un funcionario con autoridad real.

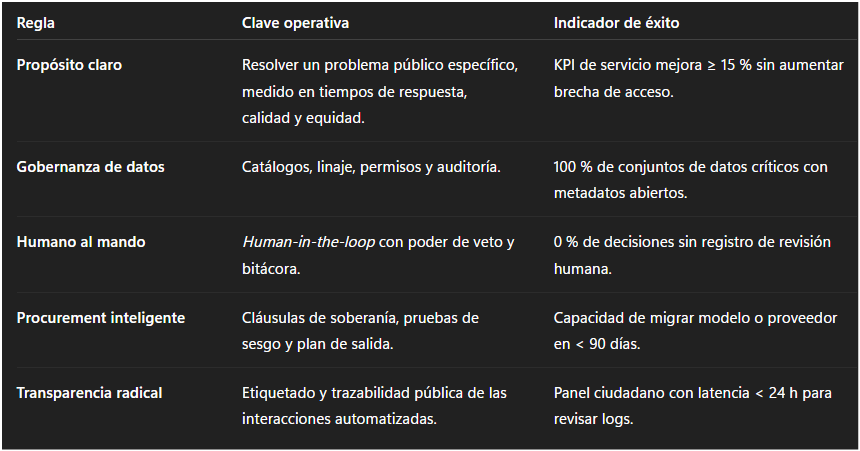

Cinco reglas prácticas para un despliegue ético y eficaz

La IA es poder, y el poder se controla

Preguntar si la IA en gobierno es buena o mala es tan improductivo como preguntarlo de la electricidad.

La IA es poder computacional aplicado a la decisión pública. Como todo poder, necesita frenos, contrapesos y rendición de cuentas.

Si la empleamos para ensanchar derechos, simplificar la vida y abrir la caja negra del Estado, será un hito civilizatorio.

Si la usamos para tercerizar criterio, reforzar sesgos o maquillar decisiones, amplificará lo que ya no funciona.

El camino aún se diseña, y la brújula es simple: más democracia, no menos, a través de la IA.

Referencias

Este artículo está inspirado sobre la publicación de Eduardo Lanes ¿Estados gobernados con Inteligencia Artificial? Eduardo Lanes, El autor es CEO de Varegos y docente universitario especializado en IA y autor del libro Humanware.

🚀 Coordinemos una sesión para generar la transformación que necesita tu empresa 💡 No esperes a que la disrupción golpee y te deje fuera del mercado ⏳ ¡Anticípate con contenidos para soñar, creer y crear el futuro! 🌍 Contáctame y juntos diseñaremos la transformación digital y exponencial 📩 que necesita tu organización 📈

Sigamos inspirando al mundo

Tu opinión es clave en esta aventura de conocimiento y transformación. ¿Qué ha parecido los contenidos de hoy? ¿Hay algún tema sobre el que te gustaría aprender más o alguna tendencia que crees que deberíamos explorar juntos?

Comparte tus ideas y sugerencias. Juntos, seguiremos inspirando, compartiendo y aprendiendo, transformando lo imposible en posible.

❓ Contáctame a través de estos puntos de contacto.