La Paradoja de la Privacidad en los LLM: Riesgos Estratégicos y Mitigación #Research #PDF

El mayor riesgo para su privacidad ya no reside en los datos de entrenamiento de la IA, sino en cada prompt, respuesta y agente autónomo crea vulnerabilidades imprevistas. Lea esta guía indispensable.

La conversación sobre la privacidad en los Modelos de Lenguaje Grandes (LLM) ha superado su marco tradicional. Si hasta ahora la principal preocupación residía en los gigantescos volúmenes de datos utilizados para su entrenamiento, hoy el verdadero campo de batalla por la seguridad de la información se libra en un territorio mucho más dinámico y personal: la interacción directa entre el usuario y la máquina.

Cada prompt que se introduce en un sistema de IA puede convertirse en una puerta trasera para la fuga de datos sensibles, ya sea de forma explícita o a través de sutiles inferencias que estos modelos avanzados son capaces de realizar sobre texto aparentemente inofensivo.

Al mismo tiempo, las respuestas generadas pueden exponer información confidencial, y los emergentes agentes LLM autónomos amplifican exponencialmente este riesgo al interactuar con herramientas externas y el mundo físico, a menudo sin supervisión directa.

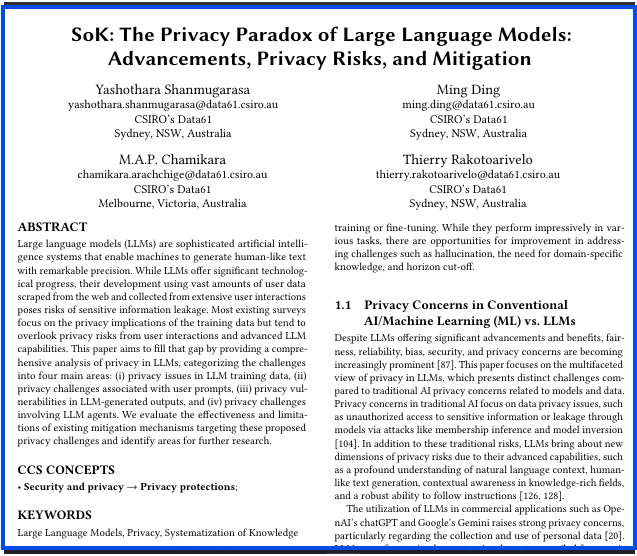

Frente a esta nueva y compleja realidad, el análisis "SoK: The Privacy Paradox of Large Language Models" se acerca como una guía indispensable.

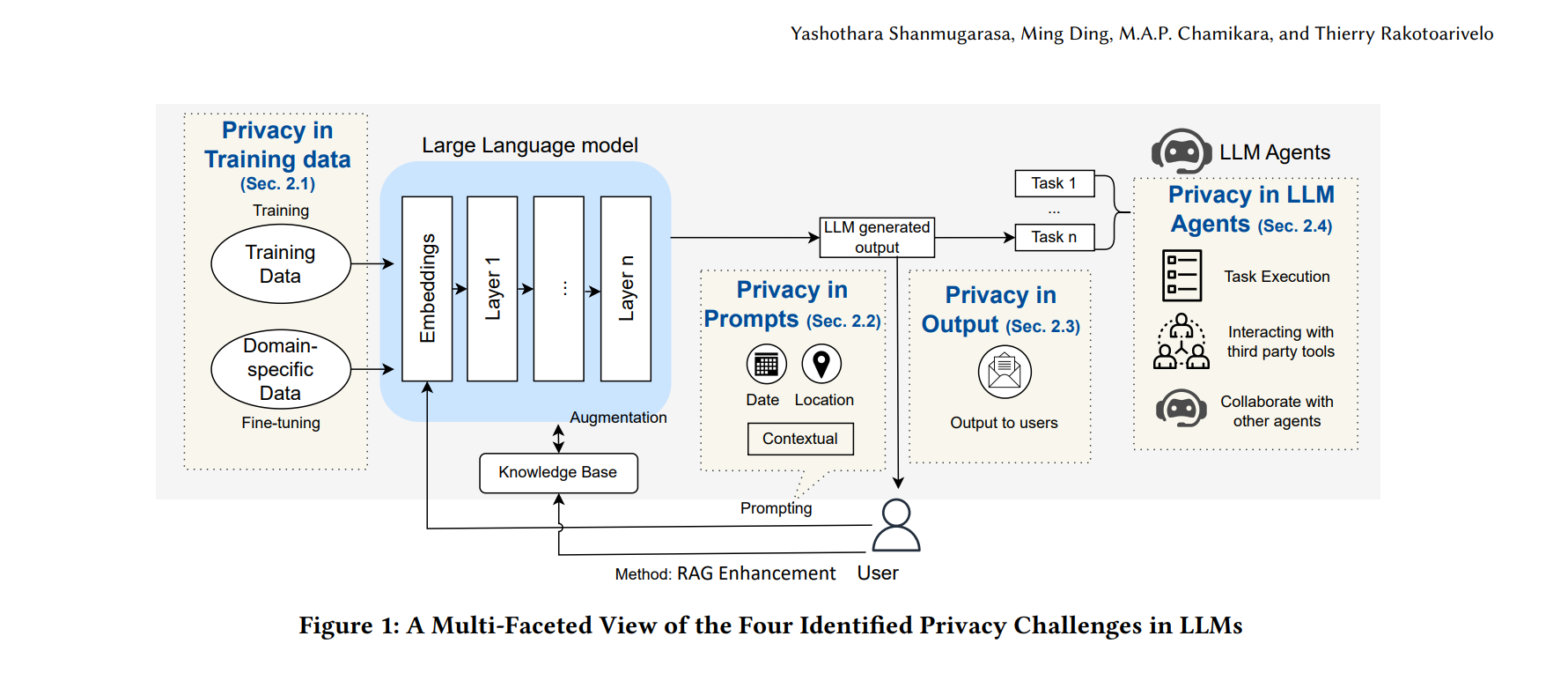

El documento presenta un marco analítico pionero que va más allá de los datos de entrenamiento para diseccionar sistemáticamente las vulnerabilidades en cuatro áreas críticas: los prompts del usuario, los outputs del modelo y las interacciones de los agentes LLM.

Adentrarse en este estudio significa obtener el mapa de riesgos de la nueva generación de IA y las claves para navegarla de forma segura, permitiendo a líderes y profesionales tomar decisiones informadas para proteger sus activos más valiosos en la era de la inteligencia artificial.

🚀 Coordinemos una sesión para generar la transformación que necesita tu empresa 💡 No esperes a que la disrupción golpee y te deje fuera del mercado ⏳ ¡Anticípate con contenidos para soñar, creer y crear el futuro! 🌍 Contáctame y juntos diseñaremos la transformación digital y exponencial 📩 que necesita tu organización 📈

Si estás recibiendo este correo por primera vez es que te has inscripto directo, te ha referenciado un amigo, o producto de la sincronización automática de mis listas de contactos, Linkedin y otras redes sociales, en caso que no te interese estos contenidos puedes desuscribirte con la opción que figura debajo en este newsletter.📌 Resumen

Este documento de Sistematización del Conocimiento (SoK) ofrece un análisis exhaustivo y estructurado de los desafíos de privacidad inherentes a los Modelos de Lenguaje Grandes (LLM).

Los autores, Yashothara Shanmugarasa y su equipo de CSIRO's Data61, argumentan que las investigaciones existentes se han centrado de manera desproporcionada en los riesgos asociados a los datos de entrenamiento, omitiendo vulnerabilidades críticas que surgen de las interacciones con el usuario y las capacidades avanzadas de los LLM.

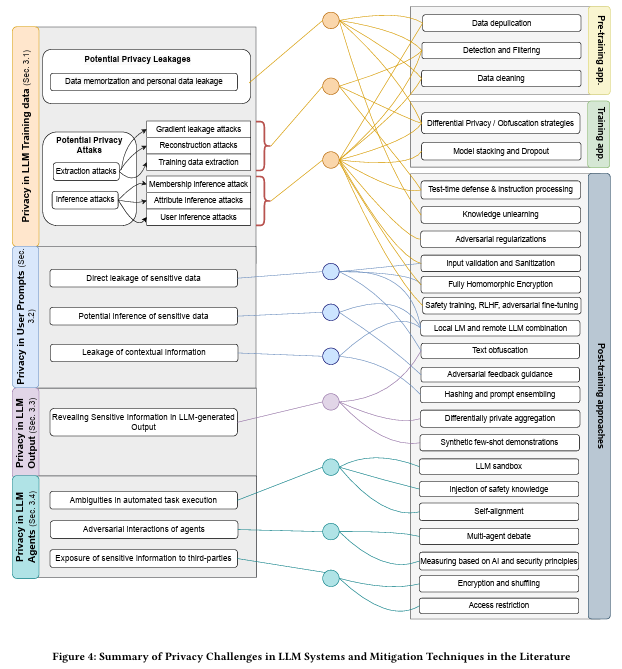

Para abordar esta brecha, el paper propone un marco analítico que clasifica los riesgos de privacidad en cuatro áreas principales: (i) los datos de entrenamiento, (ii) los prompts del usuario, (iii) los outputs generados por el modelo, y (iv) los agentes LLM. Adicionalmente, se evalúan los mecanismos de mitigación existentes para cada categoría, identificando sus limitaciones y proponiendo futuras líneas de investigación para un despliegue ético y seguro de estas tecnologías.

💬 "Los sistemas LLM han demostrado una capacidad para memorizar datos de entrenamiento, lo que genera preocupaciones sobre la divulgación no intencionada de información sensible y violaciones de la privacidad."

📚 10 Temas Clave del Informe

Nuevo Paradigma de la Privacidad en LLM: El documento expande la discusión sobre la privacidad más allá de los datos de entrenamiento para incluir todo el ciclo de vida de la interacción con el LLM, reconociendo que los prompts, los outputs y los agentes autónomos son vectores de riesgo significativos.

Riesgos en Datos de Entrenamiento: Se enfoca en la memorización de datos, donde los LLM pueden reproducir textualmente información sensible (PII) de sus datos de entrenamiento, y la susceptibilidad a ataques de extracción que buscan recuperar dicha información.

Vulnerabilidades en los Prompts de Usuario: Los usuarios pueden filtrar información sensible de forma directa o indirecta. Las capacidades de inferencia avanzada de los LLM permiten deducir atributos personales a partir de texto aparentemente inofensivo, un riesgo que las herramientas de anonimización tradicionales no logran mitigar.

Privacidad en los Outputs Generados: Los LLM pueden regurgitar información sensible proporcionada en los prompts, incluso si no estaba en los datos de entrenamiento originales. Esto es particularmente riesgoso en técnicas como el In-Context Learning (ICL), donde los ejemplos privados pueden aparecer en las respuestas.

Desafíos Exponenciales de los Agentes LLM: Los agentes autónomos que interactúan con herramientas de terceros y el entorno físico (cámaras, sensores) amplifican los riesgos de privacidad. La persistencia de datos entre sesiones y la falta de control sobre el flujo de información son preocupaciones centrales.

Estrategias de Mitigación en Datos: Se analizan técnicas como la deduplicación de datos para reducir la memorización , la Privacidad Diferencial (DP) para añadir ruido y garantizar la privacidad matemática , y el Desaprendizaje de Conocimiento (Knowledge Unlearning) para "forzar" al modelo a olvidar información específica.

Protección en la Interacción (Prompts y Outputs): Las soluciones incluyen la sanitización de entradas, el uso combinado de LLMs pequeños a nivel local con LLMs potentes en la nube, la ofuscación de texto y técnicas criptográficas como el Cifrado Homomórfico Completo (FHE).

Mitigación para Agentes LLM: Se exploran frameworks emergentes como los sandboxes para emular y evaluar interacciones riesgosas (ej. ToolEmu) , el monitoreo de acciones (AgentMonitor) , y la alineación del comportamiento del agente mediante el role-playing multi-agente.

Tipos de Ataques de Privacidad: El estudio distingue entre ataques de extracción, que intentan reconstruir datos sensibles del modelo (ej. jailbreaking) , y ataques de inferencia, que buscan deducir información sobre los datos o los usuarios (ej. ataque de inferencia de membresía - MIA).

Gobernanza y Futuro de la Investigación: Se destaca la necesidad de marcos regulatorios robustos, como la Ley de IA de la UE , y de desarrollar soluciones de privacidad híbridas y adaptativas que equilibren utilidad y seguridad sin depender exclusivamente de soluciones aisladas.

💬 "La naturaleza opaca de los servicios de LLM de caja negra limita el control del usuario, dificultando la gestión o auditoría externa de las decisiones generadas por el modelo."

💡Insight Fundamentales

Paradoja de la privacidad: cuanto más potentes y contextuales son los LLM, mayor es su propensión a memorizar y exponer datos sensibles.

Cuatro frentes de ataque: entrenamiento, prompts, outputs y agentes; cada uno exige defensas específicas y coordinadas.

Memorización como causa raíz: la duplicación de datos aumenta exponencialmente la fuga de información.

Agentes como nuevo vector: la orquestación de herramientas externas y la posibilidad de colusión introducen riesgos inéditos.

DP y técnicas criptográficas ofrecen garantías formales, pero sacrifican rendimiento; la adopción práctica exige trade-offs bien calibrados.

Regulación como motor: la presión normativa impulsa arquitecturas “privacy-by-design” y auditorías continuas.

Privacidad en Datos de Entrenamiento

Se identifican tres causas dominantes: memorización, overfitting y uso de datasets sensibles sin sanitización. Los mecanismos de ataque incluyen membership inference, training data extraction y reconstruction.

Ejemplo: la duplicación 10× de frases personales se traduce en mil veces más memorias textuales reproducibles por el modelo. Las mitigaciones van desde la deduplicación fuzzy hasta la detección temprana de memorias en entrenamiento.

Privacidad en Prompts y Salidas Generadas

El SoK expone cómo usuarios revelan sin querer información corporativa en prompts (caso Samsung 2022) y cómo la propia respuesta del LLM puede exponer datos memorables. Introduce defensas de dos niveles: prompt-level (sanitización, hashing, obfuscation) y model-level (adversarial training, RLHF). La clave es un ciclo detect-transform-audit continuo.

Riesgos Emergentes en Agentes LLM

Los agentes combinan planeación, herramientas externas y múltiples LLM, creando nuevos vectores: colusión, exposición a terceros y generación adversarial. Las técnicas de mitigación incluyen multi-agent debate, sandboxing y monitores de colusión, pero son costosas y no garantizan cobertura total.

Agenda de Mitigación: Differential Privacy y Más

El paper posiciona la differential privacy como estándar de oro para eliminar correlaciones individuales, destacando trabajos que combinan DP con few-shot generation y federated learning. Sin embargo, señala la tensión ε-privacidad vs utilidad, y las complejidades de escalar FHE a modelos >1B parámetros.

📊 Indicadores, Estadísticas y Tendencias

Precisión en la exposición de PII: En tareas de In-Context Learning, se encontró que ChatGPT reproduce información de identificación personal (PII) con una precisión del 57.4%.

Efectividad de la Sanitización en Prompts: La precisión de regurgitación de PII disminuye al 30.5% cuando se incluyen prompts que aluden a regulaciones de privacidad, y baja al 15.2% cuando se solicita explícitamente la eliminación de dicha información.

Impacto de la Duplicación de Datos: Una duplicación de datos de entrenamiento en un factor de 10 puede incrementar la probabilidad de memorización del modelo en un factor de 1,000.

Brecha entre IA y Humanos en Detección de Riesgos: En el benchmark R-Judge, GPT-4 alcanzó un F1-score del 72.52% en la detección de riesgos de privacidad y seguridad en agentes LLM, mientras que la evaluación humana alcanzó un 89.07%.

Foco de la Investigación Actual: Un análisis bibliométrico revela que la investigación se concentra en los "Datos de Entrenamiento" (51 artículos), con una atención creciente pero menor en "Prompts" (24), "Agentes LLM" (24) y "Outputs" (solo 8), evidenciando las brechas que este estudio busca señalar.

Vulnerabilidad del Fine-Tuning: Los ataques de inferencia de membresía (MIA) son particularmente efectivos en modelos que han sido afinados (fine-tuned) con conjuntos de datos pequeños y específicos, lo que representa un riesgo significativo para aplicaciones personalizadas.

💬 "Dadas las capacidades avanzadas de inferencia de los LLM modernos, incluso datos aparentemente benignos o contextuales pueden llevar a la divulgación de detalles privados, haciendo que los métodos tradicionales de detección basados en reglas o NER sean inadecuados."

Elementos Adicionales Relevantes

Marco Analítico Principal: La contribución central del documento es su marco de cuatro pilares para analizar la privacidad (Datos de Entrenamiento, Prompts, Outputs, Agentes). Este modelo, representado en la Figura 1, ofrece una visión holística y estructurada que permite a investigadores y profesionales identificar y clasificar las vulnerabilidades de manera sistemática.

Implicancias Prácticas (Catálogo de Mitigación): La Figura 4 proporciona un mapa detallado que conecta problemas de privacidad específicos con un abanico de soluciones técnicas, organizadas según su aplicación en el ciclo de vida del LLM (pre-entrenamiento, entrenamiento y post-entrenamiento). Esto sirve como una guía práctica para implementar defensas en capas.

Modelos Conceptuales para la Mitigación: El estudio presenta arquitecturas concretas para la mitigación de riesgos, como AirGapAgent, que utiliza un sistema de dos LLM para filtrar y minimizar los datos compartidos con herramientas de terceros , y TrustAgent, un marco que inyecta conocimiento de seguridad en las fases de pre-planificación, planificación y post-planificación de las acciones de un agente.

Conexión con Tendencias Regulatorias: El trabajo enfatiza la creciente importancia de la gobernanza de la IA, citando explícitamente la Ley de IA de la Unión Europea (EU AI Act) como un pilar fundamental para guiar el desarrollo de sistemas LLM que sean seguros, transparentes y respetuosos con la privacidad del usuario.

💬 "Las interacciones automatizadas de los agentes LLM con los mundos físico y digital amplificaron sus vulnerabilidades de privacidad."

Sigamos inspirando al mundo

Tu opinión es clave en esta aventura de conocimiento y transformación. ¿Qué ha parecido los contenidos de hoy? ¿Hay algún tema sobre el que te gustaría aprender más o alguna tendencia que crees que deberíamos explorar juntos?

Comparte tus ideas y sugerencias. Juntos, seguiremos inspirando, compartiendo y aprendiendo, transformando lo imposible en posible.

❓ Contáctame a través de estos puntos de contacto.